Однослойный персептрон (пример)

Материал из MachineLearning.

(→Вычислительный эксперимент) |

(→Вычислительный эксперимент) |

||

| Строка 22: | Строка 22: | ||

[[Изображение:Iris.jpg|Iris.jpg]] | [[Изображение:Iris.jpg|Iris.jpg]] | ||

| - | [[Изображение:iris.png| | + | [[Изображение:iris.png|300px]] |

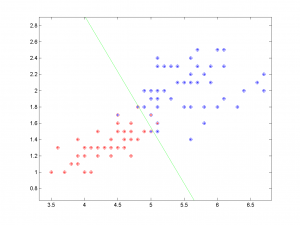

На графике показаны результаты классификации. По оси х отложено значение одного признака(длина лепестка в см)б а по оси у значение второго признака(ширина лепестка в см). Различные классы показаны крестика различных цветов, а результат классификации кружочками соотвествующего цвета. Зеленой линией показана граница между классами, построенная алгоритмом. | На графике показаны результаты классификации. По оси х отложено значение одного признака(длина лепестка в см)б а по оси у значение второго признака(ширина лепестка в см). Различные классы показаны крестика различных цветов, а результат классификации кружочками соотвествующего цвета. Зеленой линией показана граница между классами, построенная алгоритмом. | ||

Версия 18:17, 1 мая 2009

|

Однослойный персептрон — это модель нейрона, простейший пример нейронной сети. Фактически представляет собой линейный пороговый классификатор.

Постановка задачи линейного разделения классов

Пусть - пространство объектов;

- множество допустимых ответов. Будем считать, что

, где

- признаковое описание объекта, а

- дополнительный константный признак;

. Задана обучающая выборка

. Значения признаков

рассматриваются как импульсы, поступающие на вход нейрона, которые складываются с весами

. Если суммарный импульс превышает порог активации

, то нейрон возбуждается

и выдаёт на выходе 1, иначе выдаётся 0. Таким образом, нейрон вычисляет

-арную булеву функцию вида

Требуется найти значения параметров, при которых алгоритм наилучшим образом аппроксимирует целевую зависимость, заданную на объектах обучающей выборки.

Описание алгоритма

Для настройки вектора весов воспользуемся методом стохастического градиента. Возьмем квадратичную функцию потерь: , а в качестве функции активации возьмем сигмоидную функцию:

. Согласно принципу минимизации эмпирического риска задача сводится к поиску вектора, доставляющего минимум функционалу

. Применим для минимизации метод градиентного спуска:

где величина шага в направлении антиградиента, называемая также темпом обучения (learning rate). Будем выбирать прецеденты

по одному в случайном порядке, для каждого делать градиентный шаг и сразу обновлять вектор весов:

Вычислительный эксперимент

Показана работа алгоритма в серии задач, основанных как на реальных, так и на модельных данных. 1) Пример на реальных данных: ирисы. Из классической задачи о классификации ирисов выбраны 2 вида ирисов: Versicolour и Virginica, которые предлагается классифицировать по двум признакам – длине и ширине лепестка. Данные содержат информацию о 50 цветках каждого вида (iris.txt)

На графике показаны результаты классификации. По оси х отложено значение одного признака(длина лепестка в см)б а по оси у значение второго признака(ширина лепестка в см). Различные классы показаны крестика различных цветов, а результат классификации кружочками соотвествующего цвета. Зеленой линией показана граница между классами, построенная алгоритмом.

%load data load 'iris.txt'; x = iris; x(:,1) = []; %eliminating first two attributes x(:,1) = []; y = [repmat(0,50,1);repmat(1,50,1)]; %creating class labels %plotting data plot(x(y == 0,1),x(y == 0,2),'*r'); hold on plot(x(y == 1,1),x(y == 1,2),'*b'); %invoke One layer perceptron algorithm w = OneLayerPerc(x,y); %getting classification y = PercTest(x,w); %plotting resulting classification plot(x(y == 0,1),x(y == 0,2),'or'); plot(x(y == 1,1),x(y == 1,2),'ob'); plot([w(3)/w(1),0],[0,w(3)/w(2)],'g'); hold off;

Заметим, что данные линейно не разделимы, но алгоритм показывает хороший результат, допустив всего 5 ошибок классификации.

2) Модельные данные(простой вариант): 2 нормально распределенных класса линейно разделимы.

%generating 2 sample normal classes x = GetNormClass(100,[0,0],[1,1]); s = GetNormClass(100,[4,4],[1,1]); x = [x;s]; y = [repmat(1,100,1);repmat(0,100,1)]; %invoke One layer perceptron algorithm w = OneLayerPerc(x,y); %generating control data with the same distribution x = GetNormClass(100,[0,0],[1,1]); s = GetNormClass(100,[4,4],[1,1]); x = [x;s]; %plotting control data plot(x(:,1),x(:,2),'*r'); hold on plot(s(:,1),s(:,2),'*b'); %getting classification y = PercTest(x,w); %plotting classified data plot(x(y == 0,1),x(y == 0,2),'ob'); plot(x(y == 1,1),x(y == 1,2),'or'); plot([w(3)/w(1),0],[0,w(3)/w(2)],'g'); hold off

Алгоритм справился с задачей, не допустив при классификации ни одной ошибки.

Исходный код

TODO

Смотри также

TODO

Литература

- К. В. Воронцов, Лекции по линейным алгоритмам классификации

- Bishop, C. Pattern Recognition And Machine Learning. Springer. 2006.

| | Данная статья является непроверенным учебным заданием.

До указанного срока статья не должна редактироваться другими участниками проекта MachineLearning.ru. По его окончании любой участник вправе исправить данную статью по своему усмотрению и удалить данное предупреждение, выводимое с помощью шаблона {{Задание}}. См. также методические указания по использованию Ресурса MachineLearning.ru в учебном процессе. |