Сеть радиальных базисных функций

Материал из MachineLearning.

Радиальные функции — это функции , зависящие только от расстояния между x и фиксированной точ-

кой пространства X.

Гауссиан с диагональной матрицей

можно записать в виде

где — нормировочный множитель,

— взвешенная евклидова метрика в n-мерном пространстве X:

,

.

Чем меньше расстояние , тем выше значение плотности в точке x. Поэтому плотность

можно рассматривать как функцию близости вектора x к фиксированному центру

.

Содержание |

Сеть радиальных базисных функций

Пусть , каждый класс

имеет свою плотность

распределения

и представлен частью выборки

.

Гипотеза

Функции правдоподобия классов , представимы в виде

смесей

компонент. Каждая компонента имеет n-мерную гауссовскую плотность

с параметрами

:

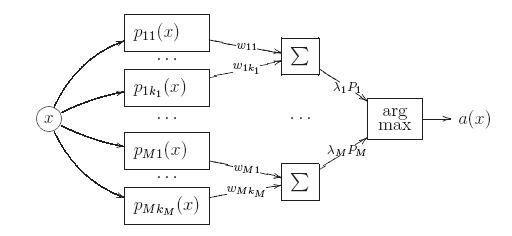

Алгоритм классификации

Запишем байесовское решающее правило, выразив плотность каждой компоненты через взвешенное евклидово расстояние от объекта x до центра компоненты

:

где — нормировочные множители. Алгоритм имеет вид

суперпозиции, состоящей из трёх уровней или слоёв.

Первый слой образован гауссианами

.

На входе они принимают описание объекта x, на выходе выдают оценки близости

объекта x к центрам

, равные значениям плотностей компонент в точке x.

Второй слой состоит из M сумматоров, вычисляющих взвешенные средние этих

оценок с весами . На выходе второго слоя появляются оценки принадлежности

объекта x каждому из классов, равные значениям плотностей классов

.

Третий слой образуется единственным блоком argmax, принимающим окончательное решение об отнесении объекта x к одному из классов.

Таким образом, при классификации объекта x оценивается его близость к каж-

дому из центров по метрике

. Объект относится к тому

классу, к чьим центрам он располагается ближе.

Описанный трёхуровневый алгоритм классификации называется сетью c радиальными базисными функциями или RBF-сетью (radial basis function network). Это одна из разновидностей нейронных сетей.

Обучение RBF-сети

Обучение сводится к восстановлению плотности каждого из классов

с помощью EM-алгоритма. Результатом обучения являются центры

и дис-

персии

компонент

. Интересно отметить, что, оценивая дисперсии,

мы фактически подбираем метрики

, с помощью которых будут вычисляться рас-стояния до центров

. При использовании Алгоритма 1.4 для каждого класса определяется оптимальное число компонент смеси.[1]

Литература

| | Данная статья является непроверенным учебным заданием.

До указанного срока статья не должна редактироваться другими участниками проекта MachineLearning.ru. По его окончании любой участник вправе исправить данную статью по своему усмотрению и удалить данное предупреждение, выводимое с помощью шаблона {{Задание}}. См. также методические указания по использованию Ресурса MachineLearning.ru в учебном процессе. |