Аппроксимация Лапласа (пример)

Материал из MachineLearning.

(→Смотри также) |

(→Сэмплирование) |

||

| Строка 3: | Строка 3: | ||

==Сэмплирование== | ==Сэмплирование== | ||

| - | '''Сэмплирование''' – метод выбора подмножества наблюдаемых величин из данного множества, для дальнейшего его анализа. | + | '''Сэмплирование''' – метод выбора подмножества наблюдаемых величин из данного множества, для дальнейшего его анализа ''(с целью выделения некоторых свойст исходного множества)''. |

Одно из основных приминений методов сэмплирования заключается в оценке математического ожидания сложных вероятностных распределений: | Одно из основных приминений методов сэмплирования заключается в оценке математического ожидания сложных вероятностных распределений: | ||

<center><tex>E[f]=\int f(z)p(z) dz</tex></center> | <center><tex>E[f]=\int f(z)p(z) dz</tex></center> | ||

| - | для которых тяжело делать выборку непосредственно из распределения ''p(z)''. Однако, можно подсчитать значение ''p(z)'' в любой точке ''z''. | + | для которых тяжело делать выборку непосредственно из распределения ''p(z)''. Однако, можно подсчитать значение ''p(z)'' в любой точке ''z''. Основная идея ''всех'' методов сэмплирования заключается в создании незавсимой выборки <tex>z^{(l)}</tex> (где <tex>l=1,...,L</tex>) из распределения ''p(z)''. Это позволит интеграл приблизить конечной суммой: |

| - | < | + | <center> <tex>\hat f=\frac{1}{L}\sum_{l=1}^{L} f(z^{(l)})</tex></center> |

Существует [http://en.wikipedia.org/wiki/Sampling_(statistics)#cite_ref-ken_black_india_0-0 несколько методов сэмплирования] для создания выборки длинны ''L'' <ref>Bishop, C. Pattern Recognition And Machine Learning. Springer. 2006., Chapter 11 Sampling Methods, p. 523-558.</ref>: | Существует [http://en.wikipedia.org/wiki/Sampling_(statistics)#cite_ref-ken_black_india_0-0 несколько методов сэмплирования] для создания выборки длинны ''L'' <ref>Bishop, C. Pattern Recognition And Machine Learning. Springer. 2006., Chapter 11 Sampling Methods, p. 523-558.</ref>: | ||

*Simple random sampling; | *Simple random sampling; | ||

Версия 01:01, 23 ноября 2010

Аппроксимация Лапласа - способ оценки параметров нахождения нормального распределения при апроксимации заданой плотности вероятности.

Содержание |

Сэмплирование

Сэмплирование – метод выбора подмножества наблюдаемых величин из данного множества, для дальнейшего его анализа (с целью выделения некоторых свойст исходного множества). Одно из основных приминений методов сэмплирования заключается в оценке математического ожидания сложных вероятностных распределений:

для которых тяжело делать выборку непосредственно из распределения p(z). Однако, можно подсчитать значение p(z) в любой точке z. Основная идея всех методов сэмплирования заключается в создании незавсимой выборки (где

) из распределения p(z). Это позволит интеграл приблизить конечной суммой:

Существует несколько методов сэмплирования для создания выборки длинны L [1]:

- Simple random sampling;

- Systematic sampling;

- Rejection sampling;

- Adaptive rejection sampling.

Постановка задачи

Задана выборка — множество значений свободных переменных и множество

соответствующих им значений зависимой переменной.

Необходимо для выбранной регрессионной модели

- показать зависимость среднеквадратичной ошибки от значений параметров модели:

;

- построить график и сделать апроксимацию Лапласа для нее;

- найти расстояния между получеными зависимостями, используя расстояние Кульбака - Лейблера.

Описание алгоритма

Расстояние Кульбака - Лейблера:

Вычислительный эксперимент

Обозначим плоность распределения SSE как , а его апроксимация лапласса

Пример 1

Задуманная функция . Берем линейную регрессионную модель с двумя параметрами:

.

Используя метод наименьших квадратов находим оптимальное значение

и

(при которых SSE минимально).

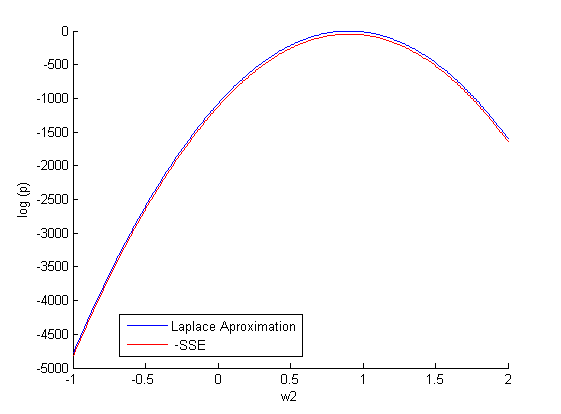

При фиксированном задаем различные значение

(500 случайных значений на отрезке [-1;2]) и строим зависимость:

.

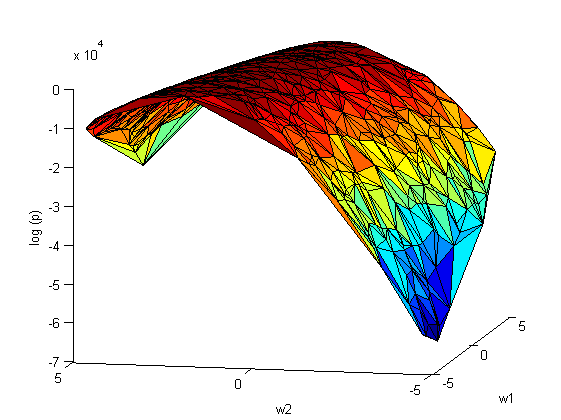

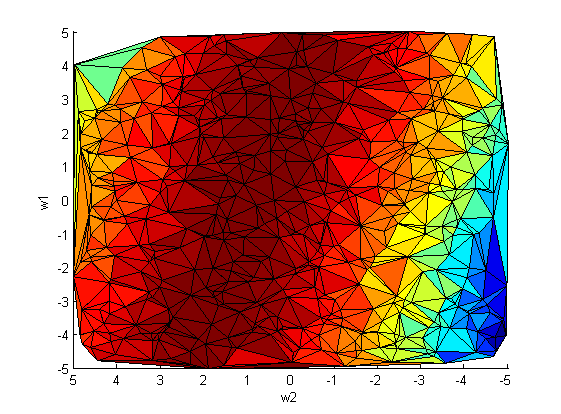

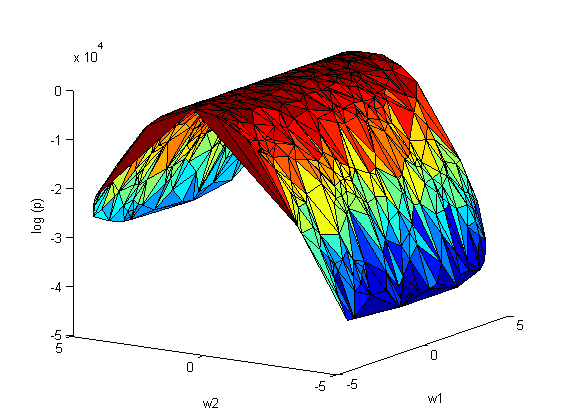

Повторим эксперимент, только теперь варируем сразу оба параметра и

:

апроксимация Лапласса:

На рис.2 наблюдается зависимость между коэффициентами и

. Следовательно, ковариационная матрица

не будет диагональной.

Смотри также

Литература

- Bishop, C. Pattern Recognition And Machine Learning. Springer. 2006.

Примечания

| | Данная статья является непроверенным учебным заданием.

До указанного срока статья не должна редактироваться другими участниками проекта MachineLearning.ru. По его окончании любой участник вправе исправить данную статью по своему усмотрению и удалить данное предупреждение, выводимое с помощью шаблона {{Задание}}. См. также методические указания по использованию Ресурса MachineLearning.ru в учебном процессе. |