Коэффициент корреляции Пирсона

Материал из MachineLearning.

м (→Статистическая проверка наличия корреляции) |

м |

||

| (3 промежуточные версии не показаны) | |||

| Строка 1: | Строка 1: | ||

{{TOCright}} | {{TOCright}} | ||

== Определение == | == Определение == | ||

| - | Коэффициент корреляции Пирсона характеризует существование | + | Коэффициент корреляции Пирсона характеризует существование линейной зависимости между двумя величинами. |

| - | + | Пусть даны две выборки <tex>x^m=\left( x_1, \cdots ,x_m \right), \; y^m=\left( y_1, \cdots ,y_m \right);</tex> коэффициент корреляции Пирсона рассчитывается по формуле: | |

| - | <tex> | + | ::<tex>r_{xy} = \frac {\sum_{i=1}^{m} \left( x_i-\bar{x} \right)\left( y_i-\bar{y} \right)}{\sqrt{\sum_{i=1}^{m} \left( x_i-\bar{x} \right)^2 \sum_{i=1}^{m} \left( y_i-\bar{y} \right)^2}} = \frac {cov(x,y)}{\sqrt{s_x^2 s_y^2}},</tex> |

| - | + | где <tex>\bar{x}, \bar{y}</tex> – выборочные средние <tex>x^m</tex> и <tex>y^m</tex>, <tex>s_x^2, s_y^2</tex> – выборочные дисперсии, <tex>r_{xy} \in \left[-1,1\right]</tex>. | |

| - | + | Коэффициент корреляции Пирсона называют также теснотой линейной связи: | |

| - | + | *<tex>\left| r_{xy} \right| =1 \;\Rightarrow\; x, y</tex> линейно зависимы, | |

| - | + | *<tex>r_{xy}=0 \;\Rightarrow\; x, y</tex> линейно независимы. | |

| - | + | ||

| - | + | ||

| - | + | ||

| - | + | ||

| - | + | ||

| - | + | ||

| - | *<tex>\left| r_{xy} \right| =1 | + | |

| - | *<tex>r_{xy}=0 | + | |

== Статистическая проверка наличия корреляции == | == Статистическая проверка наличия корреляции == | ||

| - | '''Гипотеза:''' <tex>H_0</tex>: отсутствует линейная связь между выборками x и y (<tex>r_{xy} = 0</tex>). | + | '''Гипотеза:''' <tex>H_0</tex>: отсутствует линейная связь между выборками <tex>x</tex> и <tex>y</tex> (<tex>r_{xy} = 0</tex>). |

'''Статистика критерия: ''' | '''Статистика критерия: ''' | ||

| - | <tex> T = \frac{r_{xy}\sqrt{n-2}}{sqrt{1-r^2_{xy}}} \sim t_{n-2} </tex> – [[распределение Стьюдента]] с <tex>n-2</tex> степенями свободы. | + | ::<tex> T = \frac{r_{xy}\sqrt{n-2}}{sqrt{1-r^2_{xy}}} \sim t_{n-2} </tex> – [[распределение Стьюдента]] с <tex>n-2</tex> степенями свободы. |

'''Критерий:''' | '''Критерий:''' | ||

| Строка 34: | Строка 26: | ||

== Слабые стороны == | == Слабые стороны == | ||

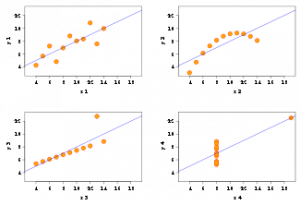

| + | [[Image: Correlation.png|300px|thumb| Четыре различных набора данных, коэффициент корреляции на которых равен 0.81]] | ||

| + | * Неустойчивость к выбросам. | ||

| - | + | * С помощью коэффициента корреляции Пирсона можно определить силу линейной зависимости между величинами, другие виды взаимосвязей выявляются методами [[Регрессионный анализ|регрессионного анализа]]. | |

| - | + | ||

| - | * С помощью коэффициента корреляции можно определить | + | |

* Необходимо понимать различие понятий "независимость" и "некоррелированность". Из первого следует второе, но не наоборот. | * Необходимо понимать различие понятий "независимость" и "некоррелированность". Из первого следует второе, но не наоборот. | ||

| - | Для того, чтобы выяснить отношение между двумя переменными, часто необходимо избавиться от влияния третьей переменной. Рассмотрим пример 3-х переменных | + | Для того, чтобы выяснить отношение между двумя переменными, часто необходимо избавиться от влияния третьей переменной. Рассмотрим пример 3-х переменных <tex>x, y, z.</tex> Исключим влияние переменной <tex>z</tex>: |

| - | :: <tex>r_{xy \setminus z}=\frac{r_{xy}-r_{xz}r_{yz}}{\sqrt{ \left(\ 1-r_{xz} \right)^2 \left(\ 1-r_{yz} \right)^2}} </tex> | + | :: <tex>r_{xy \setminus z}=\frac{r_{xy}-r_{xz}r_{yz}}{\sqrt{ \left(\ 1-r_{xz} \right)^2 \left(\ 1-r_{yz} \right)^2}} </tex> – [[Частная корреляция|частный коэффициент корреляции]]. |

Для исключения влияния большего числа переменных: | Для исключения влияния большего числа переменных: | ||

| - | :: <tex>r_{ij \setminus vars}=\frac{-R_{ij}}{\sqrt{R_{ii}R_{jj}}} | + | :: <tex>r_{ij \setminus vars}=\frac{-R_{ij}}{\sqrt{R_{ii}R_{jj}}},</tex> |

| + | |||

| + | :: <tex>R_{ij} = (-1)^{i+j}M_{ij},</tex> | ||

| + | |||

| + | где <tex>M_{ij} </tex> – главный минор матрицы коэффициентов корреляции переменных | ||

| - | + | ::<tex> R = \begin{pmatrix} 1 & r_{12} & \dots & r_{1k} \\r_{21} & 1 & & r_{2k}\\\vdots & & \ddots & \vdots \\r_{k1} & \dots & \dots & 1\end{pmatrix} .</tex> | |

| - | \begin{pmatrix} | + | |

| - | 1 & r_{12} & \dots & r_{1k} \\ | + | |

| - | r_{21} & 1 & | + | |

| - | \vdots & | + | |

| - | r_{k1} & \dots & \dots & 1 | + | |

| - | \end{pmatrix} | + | |

| - | </tex> | + | |

== Литература == | == Литература == | ||

Текущая версия

|

Определение

Коэффициент корреляции Пирсона характеризует существование линейной зависимости между двумя величинами.

Пусть даны две выборки коэффициент корреляции Пирсона рассчитывается по формуле:

где – выборочные средние

и

,

– выборочные дисперсии,

.

Коэффициент корреляции Пирсона называют также теснотой линейной связи:

линейно зависимы,

линейно независимы.

Статистическая проверка наличия корреляции

Гипотеза: : отсутствует линейная связь между выборками

и

(

).

Статистика критерия:

– распределение Стьюдента с

степенями свободы.

Критерий:

, где

есть α-квантиль распределения Стьюдента.

Слабые стороны

- Неустойчивость к выбросам.

- С помощью коэффициента корреляции Пирсона можно определить силу линейной зависимости между величинами, другие виды взаимосвязей выявляются методами регрессионного анализа.

- Необходимо понимать различие понятий "независимость" и "некоррелированность". Из первого следует второе, но не наоборот.

Для того, чтобы выяснить отношение между двумя переменными, часто необходимо избавиться от влияния третьей переменной. Рассмотрим пример 3-х переменных Исключим влияние переменной

:

Для исключения влияния большего числа переменных:

где – главный минор матрицы коэффициентов корреляции переменных