Математические основы теории прогнозирования (курс лекций, Ю.И. Журавлев, Д.П. Ветров)/2011/Задание СФ

Материал из MachineLearning.

(описание логистической регрессии) |

м (несколько запятых) |

||

| (24 промежуточные версии не показаны) | |||

| Строка 1: | Строка 1: | ||

| - | {{ | + | {{TOCright|300px}} |

| - | + | <!-- [[Изображение:MOTP11_wine2.jpg|150px]] [[Изображение:MOTP11_logreg.jpg|200px]] --> | |

| - | <!-- | + | |

| - | + | ||

| - | [[Изображение: | + | |

[[Математические основы теории прогнозирования (курс лекций, Ю.И. Журавлев, Д.П. Ветров)|Перейти к основной странице курса]] | [[Математические основы теории прогнозирования (курс лекций, Ю.И. Журавлев, Д.П. Ветров)|Перейти к основной странице курса]] | ||

| - | ''' | + | '''Срок сдачи задания''': {{ins|1 сентября 2011, 23:59}} |

| - | + | Данное практическое задание предназначено, в первую очередь, для студентов Севастопольского филиала, которые имеют задолженность по курсу [[МОТП]] и не имеют возможности присутствовать в Москве на пересдачах осенью — Талалуева Кирилла, Пантелеева Ивана, Щербаткина Егора, Клименко Александра и Сребняка Ивана. Тем не менее, это задание могут выполнять и московские студенты ВМиК, которые имеют задолженность по курсу МОТП. Оценка за это задание будет итоговой оценкой по курсу МОТП. | |

| - | + | Цель данного задания состоит в том, чтобы студенты познакомились на практике с простейшими методами решения задач регрессии и классификации — линейной и логистической регрессией соответственно, а также с базовыми аспектами, с которыми приходится сталкиваться при решении задач машинного обучения — проблемой переобучения и проблемой подбора структурных параметров алгоритмов (в данном случае в качестве таковых выступают коэффициенты регуляризации и параметры базисных функций). | |

| - | + | == Необходимая теория == | |

| - | == Линейная регрессия == | + | === Линейная регрессия === |

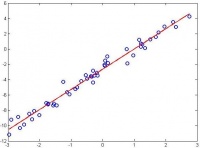

| + | [[Изображение:MOTP11_linreg.jpg|200px|thumb|Иллюстрация линейной регрессии]] | ||

Рассматривается задача регрессии. Имеется обучающая выборка <tex>\{\vec{x}_n,t_n\}_{n=1}^N</tex>, где <tex>\vec{x}_n\in\mathbb{R}^d</tex> — вектор признаков для объекта <tex>n</tex>, а <tex>t_n\in\mathbb{R}</tex> — значение его регрессионной переменной. Задача заключается в предсказании значения регрессионной переменной <tex>t_{new}</tex> для объекта, представленного своим вектором признаков <tex>\vec{x}_{new}</tex>. | Рассматривается задача регрессии. Имеется обучающая выборка <tex>\{\vec{x}_n,t_n\}_{n=1}^N</tex>, где <tex>\vec{x}_n\in\mathbb{R}^d</tex> — вектор признаков для объекта <tex>n</tex>, а <tex>t_n\in\mathbb{R}</tex> — значение его регрессионной переменной. Задача заключается в предсказании значения регрессионной переменной <tex>t_{new}</tex> для объекта, представленного своим вектором признаков <tex>\vec{x}_{new}</tex>. | ||

| Строка 25: | Строка 23: | ||

где <tex>w_j\in\mathbb{R}</tex> — веса линейного решающего правила, а <tex>\phi_j:\mathbb{R}^d\rightarrow\mathbb{R}</tex> — фиксированные базисные функции (новые признаки). Примеры базисных функций: | где <tex>w_j\in\mathbb{R}</tex> — веса линейного решающего правила, а <tex>\phi_j:\mathbb{R}^d\rightarrow\mathbb{R}</tex> — фиксированные базисные функции (новые признаки). Примеры базисных функций: | ||

# ''Исходные признаки'': <tex>\phi_j(\vec{x})=x_j</tex>; | # ''Исходные признаки'': <tex>\phi_j(\vec{x})=x_j</tex>; | ||

| - | # '' | + | # ''Полиномиальные базисные функции'': <tex>\phi_j(\vec{x})=x_{j_1}x_{j_2}\dots x_{j_k},\ j_1,\dots,j_k\in\{1,\dots,d\},\ 1\le k\le K,\ K</tex> — степень полинома; |

# ''Радиальные базисные функции'': <tex>\phi_j(\vec{x})=\exp(-\gamma||\vec{x}-\vec{x}_j||^2)</tex>, где <tex>\gamma>0</tex>, а <tex>\vec{x}_j</tex> — некоторые заранее выбранные опорные объекты, например, объекты обучающей выборки. | # ''Радиальные базисные функции'': <tex>\phi_j(\vec{x})=\exp(-\gamma||\vec{x}-\vec{x}_j||^2)</tex>, где <tex>\gamma>0</tex>, а <tex>\vec{x}_j</tex> — некоторые заранее выбранные опорные объекты, например, объекты обучающей выборки. | ||

| Строка 36: | Строка 34: | ||

<tex>\vec{w}_{opt}=\Biggl(\frac{1}{N}\Phi^T\Phi + \lambda I\Biggr)^{-1}\frac{1}{N}\Phi^T\vec{t}</tex>. | <tex>\vec{w}_{opt}=\Biggl(\frac{1}{N}\Phi^T\Phi + \lambda I\Biggr)^{-1}\frac{1}{N}\Phi^T\vec{t}</tex>. | ||

| - | == Логистическая регрессия == | + | === Логистическая регрессия === |

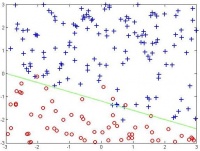

| + | [[Изображение:MOTP11_logreg.jpg|200px|thumb|Иллюстрация логистической регрессии]] | ||

Рассматривается задача классификации на два класса. Имеется обучающая выборка <tex>\{\vec{x}_n,t_n\}_{n=1}^N</tex>, где <tex>\vec{x}_n\in\mathbb{R}^d</tex> — вектор признаков для объекта <tex>n</tex>, а <tex>t_n\in\{-1,+1\}</tex> — его метка класса. Задача заключается в предсказании метки класса <tex>t_{new}</tex> для объекта, представленного своим вектором признаков <tex>\vec{x}_{new}</tex>. | Рассматривается задача классификации на два класса. Имеется обучающая выборка <tex>\{\vec{x}_n,t_n\}_{n=1}^N</tex>, где <tex>\vec{x}_n\in\mathbb{R}^d</tex> — вектор признаков для объекта <tex>n</tex>, а <tex>t_n\in\{-1,+1\}</tex> — его метка класса. Задача заключается в предсказании метки класса <tex>t_{new}</tex> для объекта, представленного своим вектором признаков <tex>\vec{x}_{new}</tex>. | ||

| Строка 49: | Строка 48: | ||

Здесь <tex>\lambda\ge 0</tex> — задаваемый пользователем параметр регуляризации. Функционал <tex>J</tex> является выпуклой функцией относительно своих параметров <tex>\vec{w}</tex> и поэтому может быть эффективно минимизирован с помощью любого итерационного метода безусловной оптимизации, учитывающего значения градиента и гессиана функции <tex>J</tex>, например, метода Ньютона. | Здесь <tex>\lambda\ge 0</tex> — задаваемый пользователем параметр регуляризации. Функционал <tex>J</tex> является выпуклой функцией относительно своих параметров <tex>\vec{w}</tex> и поэтому может быть эффективно минимизирован с помощью любого итерационного метода безусловной оптимизации, учитывающего значения градиента и гессиана функции <tex>J</tex>, например, метода Ньютона. | ||

| + | === Скользящий контроль === | ||

| + | В алгоритмах линейной/логистической регрессии параметр регуляризации <tex>\lambda</tex>, а также параметры базисных функций (например, степень полинома или параметр <tex>\gamma</tex> в радиальных базисных функциях) являются структурными параметрами, которые | ||

| + | не могут быть настроены путем минимизации критерия <tex>J</tex> на обучающей выборке. Для их настройки используются ''критерии выбора модели'', например, скользящий контроль. | ||

| - | == | + | Обозначим обучающую выборку через <tex>Y=(X,\vec{t})</tex>, а через <tex>a(\vec{x},Y)</tex> результат прогноза (значение регрессионной переменной или метки класса) для объекта <tex>\vec{x}</tex>, полученный с помощью алгоритма <tex>a</tex>, обученного по выборке <tex>Y</tex>. |

| + | При <tex>K</tex>-кратном скользящем контроле обучающая выборка <tex>Y</tex> разбивается на <tex>K</tex> равных частей <tex>Y=Y_1\sqcup Y_2\sqcup\dots\sqcup Y_K</tex>. Общая величина ошибки на <tex>K</tex>-кратном скользящем контроле вычисляется как | ||

| - | + | <tex>Error_{cv} = \frac{1}{N}\sum_{k=1}^K\ \sum_{n:\vec{x}_n\in Y_k}error(t_n, a(\vec{x}_n, Y_{\backslash k}))</tex>. | |

| - | + | ||

| - | <tex> | + | |

| - | + | ||

| - | </tex> | + | |

| - | + | ||

| - | + | Здесь через <tex>Y_{\backslash k}</tex> обозначена обучающая выборка без части <tex>Y_k</tex>, а через <tex>error(t, y)</tex> — величина ошибки между предсказанием <tex>y</tex> и истинным значением <tex>t</tex>. Эта ошибка вычисляется как | |

| - | + | ||

| - | + | ||

| - | + | ||

| - | + | <tex>error(t,y)=(t-y)^2</tex> — для задачи регрессии и <tex>error(t,y)=\begin{cases}0,\ t=y,\\1,\ t\neq y,\end{cases}</tex> — для задачи классификации. | |

| - | + | ||

| - | + | ||

| - | + | ||

| - | + | ||

| - | + | Наиболее популярная версия скользящего контроля — усреднение <tex>Error_{cv}</tex> по пяти независимым запускам 2-кратного скользящего контроля. При таком подходе необходимо обучать алгоритм только по половине обучающей выборки (что происходит быстрее, чем обучение, например, по 9/10 от объема обучающей выборки). Во-вторых, здесь требуется всего 10 различных обучений (что гораздо меньше, чем, например, объем обучающей выборки <tex>N</tex> при разбиении выборки на <tex>K=N</tex> частей). | |

| - | + | ||

| - | + | ||

| - | + | Настройка параметра регуляризации <tex>\lambda</tex> с помощью скользящего контроля производится следующим образом. Выбирается набор возможных значений <tex>\lambda</tex>, например, <tex>2^{-5},2^{-4.9},\dots,2^{4.9},2^{5}</tex>. Для каждого из этих значений вычисляется величина ошибки скользящего контроля (например, с помощью усреднения по пяти запускам 2-кратного скользящего контроля). В результате выбирается такое значение <tex>\lambda</tex>, для которого величина ошибки является наименьшей. В том случае, если требуется настроить два параметра, например <tex>\lambda</tex> и <tex>\gamma</tex> в радиальных базисных функциях, то выбирается двухмерная сетка значений параметров и находится та пара, для которой ошибка на скользящем контроле является наименьшей. | |

| - | + | ||

| - | + | ||

| - | + | ||

| - | + | ||

| - | + | ||

| - | + | ||

| - | == | + | === Схема решения задач классификации/регрессии === |

| - | + | В простейшем случае для решения задачи классификации/регрессии имеющаяся в распоряжении выборка разбивается на три подвыборки: обучающую, валидационную и тестовую. Сначала выбирается некоторая модель алгоритмов, например, линейная регрессия с полиномиальными базисными функциями. По обучающей выборке в скользящем контроле настраиваются все структурные параметры выбранной модели (для линейной регрессии с полиномиальными базисными функциями в качестве таковых выступают коэффициент регуляризации и степень полинома). Затем с выбранными значениями структурных параметров производится обучение модели алгоритмов по обучающей выборке. Полученный алгоритм тестируется на обучающей и валидационной выборке. В том случае, если значения обеих ошибок значимо отличаются друг от друга (следовательно, есть переобучение) или их значения близки между собой и достаточно большие (значит, есть недообучение), то выбранная модель алгоритмов признается неудачной и выбирается другая модель алгоритмов (более простая, если ранее было обнаружено переобучение, или более сложная, если ранее было обнаружено недообучение). После того, как удается найти хорошую модель алгоритмов (у которой нет переобучения и недообучения), обучающая и валидационная выборка объединяются между собой и используются в качестве обучающей для настройки структурных параметров по скользящему контролю и последующего обучения в найденной хорошей модели алгоритмов. Затем полученный алгоритм тестируется на объединенной обучающей и тестовой выборке. Если обе ошибки близки между собой и достаточно маленькие по значению, то такой алгоритм признается оптимальным для решения задачи классификации/регрессии. | |

| - | + | ||

| - | + | Зачастую имеющаяся в распоряжении выборка прецедентов является небольшой по объему и поэтому не может быть разбита на три достаточно репрезентативные подвыборки. В этом случае выборка разбивается только на обучающую и валидационную, и найденная по описанной выше схеме наилучшая модель алгоритмов не тестируется на отдельной тестовой выборке. Такой подход является менее корректным по сравнению с предыдущим, т.к. мерой качества алгоритма здесь выступает величина, которая подвергалась оптимизации на имеющихся данных. Поэтому здесь возможен эффект переобучения на уровне моделей алгоритмов. Тем не менее, во многих практических ситуациях данная схема дает вполне приемлемый результат. | |

| - | + | ||

| - | + | == Формулировка задания == | |

| - | + | ||

| - | + | Для выполнения задания необходимо выполнить следующие пункты: | |

| - | + | {|style="background:#E0FFE0" | |

| - | + | |1. Реализовать процедуру обучения/тестирования/подбора структурных параметров линейной регрессии по описанному ниже прототипу; | |

| + | |- | ||

| + | |2. Продемонстрировать на модельных данных для линейной регрессии эффект переобучения (маленькая ошибка на обучении, большая ошибка на тесте), эффект недообучения (ошибки на обучении и тесте близки между собой и большие по величине) и ситуацию нормальной работы (ошибки на обучении и тесте близки между собой и маленькие по величине); | ||

| + | |- | ||

| + | |3. Решить с помощью линейной регрессии практическую задачу прогноза предела прочности бетона (описание задачи см. ниже); | ||

| + | |- | ||

| + | |4. Вывести и вставить в отчет формулы для градиента и гессиана функционала <tex>J</tex> в логистической регрессии по параметрам <tex>\vec{w}</tex>; | ||

| + | |- | ||

| + | |5. Реализовать процедуру обучения/тестирования/подбора структурных параметров логистической регрессии по описанному ниже прототипу; | ||

| + | |- | ||

| + | |6. Продемонстрировать на модельных данных для логистической регрессии эффект переобучения (маленькая ошибка на обучении, большая ошибка на тесте), эффект недообучения (ошибки на обучении и тесте близки между собой и большие по величине) и ситуацию нормальной работы (ошибки на обучении и тесте близки между собой и маленькие по величине); | ||

| + | |- | ||

| + | |7. Решить с помощью логистической регрессии практическую задачу определения района происхождения вина по данным его химического анализа (описание задачи см. ниже); | ||

| + | |- | ||

| + | |8. Составить отчет в формате PDF обо всех проведенных исследованиях; данный отчет должен содержать необходимые графики и описание экспериментов, выводы необходимых формул, описание полученных результатов решения практических задач, общие выводы по исследованию. | ||

| + | |} | ||

| + | |||

| + | Для выполнения задания на оценку «удовлетворительно» достаточно реализовать только пункты 4–8 без семейства полиномиальных базисных функций. Для выполнения задания на оценку «хорошо» и «отлично» необходимо выполнить все пункты задания. | ||

=== Спецификация реализуемых функций === | === Спецификация реализуемых функций === | ||

| + | |||

| + | Рекомендуемая среда для выполнения задания — MATLAB. При выполнении задания в среде MATLAB необходимые алгоритмы должны быть реализованы по прототипам, указанным ниже. В случае использования других сред для выполнения задания, реализуемые функции должны соответствовать прототипам, описанным ниже. Например, при программировании на языке C набор параметров для обучения должен задаваться в текстовом файле, при этом список параметров и их возможные значения следует брать из прототипов ниже. | ||

| + | |||

{|class="standard" | {|class="standard" | ||

| - | !'' | + | !''Обучение линейной регрессии'' |

| - | + | ||

| - | + | ||

|- | |- | ||

| - | | | + | |a = linreg_train(X, t, options) |

|- | |- | ||

|ВХОД | |ВХОД | ||

| Строка 107: | Строка 108: | ||

| | | | ||

{|border="0" | {|border="0" | ||

| - | | | + | |X — обучающая выборка, матрица типа double размера N x M, где N — число объектов, M — число признаков. |

|- | |- | ||

| - | | | + | |t — значение регрессионной переменной, вектор типа double размера 1 x N; |

|- | |- | ||

| - | | | + | |options — (необязательный аргумент) набор дополнительных параметров, структура размера 1 x 1, названия полей структуры совпадают с названиями параметров. Возможны следующие имена параметров и их значения: |

|- | |- | ||

| - | | | + | | 'reg_coef' — значение коэффициента регуляризации (по умолчанию = 1e-6); |

|- | |- | ||

| - | | ' | + | | 'reg_coef_tuning' — флаг использования скользящего контроля для настройки коэффициента регуляризации, тип logical, если false, то используется значение из reg_coef (по умолчанию = false); |

|- | |- | ||

| - | | ' | + | | 'basis_functions' — семейство используемых базисных функций, тип char размера 1 x S, возможные значения 'initial', 'polynomial', 'rbf' (по умолчанию = 'initial'); |

|- | |- | ||

| - | | 'display' — параметр | + | | 'basis_functions_param' — значение параметра для базисных функций, тип double размера 1 x 1, для семейства 'rbf' здесь задается значение параметра gamma, для семейства 'polynomial' — степень полинома (по умолчанию = 1); |

| + | |- | ||

| + | | 'basis_functions_tuning' — флаг использования скользящего контроля для подбора параметров базисных функций, тип logical, если false, то используется значение из basis_functions_param (по умолчанию = false); | ||

| + | |- | ||

| + | | 'display' — параметр отображения, тип logical, если false, то на экране ничего не отображается, если true, то отображается текущий статус вычислений в произвольной форме (какие значения параметров пробуются, какие ошибки на скользящем контроле получаются, какие итоговые значения параметров оказались наилучшими и т.д.); | ||

|} | |} | ||

|- | |- | ||

| Строка 126: | Строка 131: | ||

| | | | ||

{| | {| | ||

| - | | | + | |a — обученная модель линейной регрессии, структура размера 1 x 1, поля структуры имеют следующие имена и значения: |

| + | {|border="0" | ||

| + | |'w' — веса линейного решающего правила, вектор типа double размера 1 x M1, где M1 — число базисных функций (для базисных функций initial M1=M+1, для базисных функций polynomial <tex>M1 = \sum_{k=1}^KC_M^k+1</tex>, K=basis_functions_param, для базисных функций rbf M1=N+1, единица добавляется в M1 за счет свободного члена, т.е. базисной функции <tex>\phi(\vec{x})\equiv 1</tex>); | ||

| + | |- | ||

| + | |'basis_functions' — семейство используемых базисных функций, совпадает с входным значением 'basis_functions'; | ||

| + | |- | ||

| + | |'basis_functions_param' — параметр базисных функций, совпадает с входным значением 'basis_functions_param'; | ||

| + | |- | ||

| + | |'support_objects' — набор опорных объектов для базисных функций rbf, совпадает с обучающей выборкой, если 'basis_functions' == 'rbf', иначе пусто; | ||

| + | |- | ||

| + | |'m' — нормировочные средние значения для каждого признака, вектор типа double размера 1 x M1; | ||

| + | |- | ||

| + | |'s' — нормировочные дисперсии для каждого признака, вектор типа double размера 1 x M1. | ||

| + | |} | ||

| + | |} | ||

| + | |} | ||

| + | Обратите внимание: параметры N и M определяются неявно по размеру соответствующих элементов. | ||

| + | |||

| + | {|class="standard" | ||

| + | !''Тестирование линейной регрессии'' | ||

| + | |- | ||

| + | |[Outputs, ErrorRate] = linreg_test(a, X, t) | ||

| + | |- | ||

| + | |ВХОД | ||

| + | |- | ||

| + | | | ||

| + | {|border="0" | ||

| + | |a — обученная модель линейной регрессии, структура, которую возвращает функция linreg_train; | ||

|- | |- | ||

| - | | | + | |X — тестовая выборка, матрица типа double размера N_test x M; |

|- | |- | ||

| - | | | + | |t — (необязательный аргумент), истинные значения целевой переменной для тестовой выборки, вектор типа double размера 1 x N_test. |

| + | |} | ||

| + | |- | ||

| + | |ВЫХОД | ||

| + | |- | ||

| + | | | ||

| + | {|border="0" | ||

| + | |Outputs — прогноз значений регрессионной переменной, вектор типа double размера 1 x N_test; | ||

|- | |- | ||

| - | | | + | |ErrorRate — (если вектор t задан) <tex>\sqrt{\frac{1}{N_{test}}\sum_{n=1}^{N_{test}}(t_n-Outputs_n)^2}</tex>; |

|} | |} | ||

| - | |} | + | |} |

| - | + | ||

| + | Прототип функции обучения логистической регрессии logreg_train целиком повторяет прототип linreg_train. При этом вектор меток класса <tex>\vec{t}</tex> должен содержать значения только 1 и 2. | ||

{|class="standard" | {|class="standard" | ||

| - | !'' | + | !''Тестирование логистической регрессии'' |

|- | |- | ||

| - | |[ | + | |[Outputs, Answers, ErrorRate] = logreg_test(a, X, t) |

|- | |- | ||

|ВХОД | |ВХОД | ||

| Строка 146: | Строка 186: | ||

| | | | ||

{|border="0" | {|border="0" | ||

| - | | | + | |a — обученная модель логистической регрессии, структура, которую возвращает функция logreg_train; |

|- | |- | ||

| - | | | + | |X — тестовая выборка, матрица типа double размера N_test x M; |

| + | |- | ||

| + | |t — (необязательный аргумент), истинные значения меток класса для тестовой выборки, вектор типа double размера 1 x N_test. | ||

|} | |} | ||

|- | |- | ||

| Строка 154: | Строка 196: | ||

|- | |- | ||

| | | | ||

| - | {| | + | {|border="0" |

| - | | | + | |Outputs — значения линейной функции <tex>f(\vec{x})</tex> для объектов тестовой выборки, вектор типа double размера 1 x N_test; |

| + | |- | ||

| + | |Answers — спрогнозированные метки класса для объектов тестовой выборки, вектор типа double размера 1 x N_test; | ||

| + | |- | ||

| + | |ErrorRate — (если вектор t задан) процент допущенных ошибок классификации. | ||

|} | |} | ||

|} | |} | ||

| - | |||

| - | |||

=== Рекомендации по выполнению задания === | === Рекомендации по выполнению задания === | ||

| - | |||

| - | |||

| - | |||

| - | + | 1. Эффективное программирование под MATLAB предполагает активнейшее использование векторных и матричных операций. В частности, по возможности следует избегать любых циклов. Например, для вычисления матрицы попарных расстояний между набором объектов, задаваемых матрицами <tex>X</tex> и <tex>Y</tex>, можно воспользоваться свойством <tex>||\vec{x}-\vec{y}||^2=||\vec{x}||^2 - 2\vec{x}^T\vec{y} + ||\vec{y}||^2</tex>, что в MATLAB может быть реализовано как | |

| - | + | <pre> | |

| - | + | normX = sum(X.^2,2); | |

| - | + | normY = sum(Y.^2,2); | |

| - | + | diffXY = bsxfun(@plus, bsxfun(@plus, -2*X*Y', normX), normY'); | |

| - | <tex>\ | + | </pre> |

| - | + | ||

| - | + | ||

| - | + | ||

| - | + | ||

| - | + | ||

| - | + | ||

| - | + | 2. При работе с выборками для устойчивости всех производимых вычислений рекомендуется осуществлять нормировку выборки независимо для каждого признака таким образом, чтобы среднее значение по выборке равнялось нулю, а выборочная дисперсия — единице. При этом следует иметь в виду, что для тестовых выборок нужно использовать нормировочные коэффициенты, полученные для обучающих выборок. | |

| - | + | 3. Проверять корректность реализации обучения и тестирования линейной/логистической регрессии следует, в первую очередь, на модельных данных. Например, для проверки линейной регрессии можно сгенерировать данные с одним признаком, в которых регрессионная переменная вычисляется как значение полинома некоторой степени от значения признака со сгенерированными коэффициентами плюс небольшой нормальный шум. Тогда при обучении линейной регрессии с полиномиальными базисными функциями и правильной степенью полинома результат предсказания должен быть очень хорошим. Эту ситуацию можно отобразить и визуально. Например, для случая полинома первой степени картинка может выглядеть так: | |

| - | + | [[Изображение:MOTP11_linreg.jpg|200px]] | |

| - | + | Кроме того, при автоматическом определении степени полинома по скользящему контролю выбираемое значение степени должно совпадать или быть близким к истинному. | |

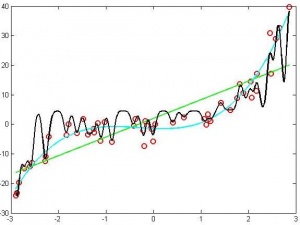

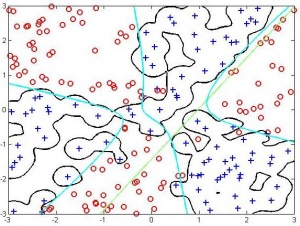

| - | [[ | + | 4. Эффекты переобучения/недообучения для линейной/логистической регрессии можно продемонстрировать следующим образом. Для линейной регрессии достаточно сгенерировать одномерные данные с полиномом 3-ей степени. Тогда обучение линейной регрессии с полиномиальными базисными функциями первой степени должно приводить к недообучению, >6-ой степени — к переобучению, а 3-ей степени — к адекватному восстановлению зависимости. Для логистической регрессии можно сгенерировать двухмерные данные с существенно нелинейной разделяющей поверхностью. Тогда обучение логистической регрессии с радиальными базисными функциями и маленьким значением <tex>\gamma</tex> должно приводить к недообучению, с большим значением <tex>\gamma</tex> — к переобучению, а некоторое среднее значение <tex>\gamma</tex> будет соответствовать адекватной разделяющей поверхности. |

| + | |||

| + | {|align="left" | ||

| + | |-valign="top" | ||

| + | |[[Изображение:MOTP11_linreg_underoverfitting.jpg|мини|300px|Различные модели линейной регрессии. Зеленая кривая — недообучение, черная кривая — переобучение, голубая кривая — адекватная зависимость]] | ||

| + | |[[Изображение:MOTP11_logreg_underoverfitting.jpg|мини|300px|Различные модели логистической регрессии. Зеленое решающее правило — недообучение, черное решающее правило — переобучение, голубое решающее правило — адекватное разделение данных]] | ||

| + | |}<br clear="all" /> | ||

| + | |||

| + | === Описание практических задач === | ||

| + | |||

| + | {|class="standard" | ||

| + | ! colspan="2"|Определение предела прочности бетона || colspan="2"|Классификация вин по месту происхождения | ||

| + | |-valign="top" | ||

| + | |[[Изображение:MOTP11_concrete.jpg|thumb|100px]] || width="40%"|Задача состоит в том, чтобы спрогнозировать уровень давления, при котором конкретная бетонная смесь разрушается, в зависимости от процента содержания в ней цемента, воды, возраста смеси и др. показателей. Исходные данные и подробное описание задачи можно скачать [http://archive.ics.uci.edu/ml/datasets/Concrete+Compressive+Strength здесь]. || width="40%"|Имеется набор вин, произведенных в одном регионе Италии, но в трех разных винодельнях. Задача состоит в том, чтобы определить конкретную винодельню (конкретное место происхождения вина) по данным химического анализа вина. Эти данные включают в себя такие параметры как крепость, содержание яблочной кислоты, содержание различных видов флавоноидов и др. Исходные данные и подробное описание задачи можно скачать [http://archive.ics.uci.edu/ml/datasets/Wine здесь]. || [[Изображение:MOTP11_wine.jpg|thumb|200px]] | ||

| + | |} | ||

| + | |||

| + | == Процедура сдачи задания == | ||

=== Оформление задания === | === Оформление задания === | ||

| - | + | Необходимо {{важно|в срок до 1 сентября 2011}} прислать выполненный вариант задания письмом по адресу ''bayesml@gmail.com'' с темой «Задание СФ, ФИО, номер группы». Убедительная просьба присылать выполненное задание '''только один раз''' с окончательным вариантом. Новые версии будут рассматриваться только в самом крайнем случае. Также убедительная просьба строго придерживаться заданной выше спецификации реализуемых функций. Очень трудно проверять большое количество заданий, если у каждого будет свой формат реализации. | |

Письмо должно содержать: | Письмо должно содержать: | ||

*PDF-файл с описанием проведенных исследований (отчет должен включать в себя описание выполнения каждого пункта задания с приведением соответствующих графиков, изображений, чисел) | *PDF-файл с описанием проведенных исследований (отчет должен включать в себя описание выполнения каждого пункта задания с приведением соответствующих графиков, изображений, чисел) | ||

| - | * | + | *Файлы linreg_train.m, linreg_test.m, logreg_train.m, logreg_test.m или аналогичные им исполняемые файлы |

| - | + | ||

*Набор вспомогательных файлов при необходимости | *Набор вспомогательных файлов при необходимости | ||

| + | |||

| + | === Защита задания === | ||

| + | |||

| + | После сдачи выполненного задания и его проверки необходимо будет защитить свое задание. В том случае, если в какой-то части выполненного задания будет обнаружен плагиат с заданием другого студента, то '''задание не будет засчитано для обоих студентов'''! Защита задания будет осуществляться с помощью видео-чата для студентов СФ и во время осенних пересдач для московских студентов. Студенту будет предложен ряд вопросов по присланному коду и проведенным исследованиям. Кроме того, возможны задания по небольшой модификации кода в режиме онлайн. | ||

[[Категория:Учебные курсы]] | [[Категория:Учебные курсы]] | ||

Текущая версия

|

Перейти к основной странице курса

Срок сдачи задания: 1 сентября 2011, 23:59

Данное практическое задание предназначено, в первую очередь, для студентов Севастопольского филиала, которые имеют задолженность по курсу МОТП и не имеют возможности присутствовать в Москве на пересдачах осенью — Талалуева Кирилла, Пантелеева Ивана, Щербаткина Егора, Клименко Александра и Сребняка Ивана. Тем не менее, это задание могут выполнять и московские студенты ВМиК, которые имеют задолженность по курсу МОТП. Оценка за это задание будет итоговой оценкой по курсу МОТП.

Цель данного задания состоит в том, чтобы студенты познакомились на практике с простейшими методами решения задач регрессии и классификации — линейной и логистической регрессией соответственно, а также с базовыми аспектами, с которыми приходится сталкиваться при решении задач машинного обучения — проблемой переобучения и проблемой подбора структурных параметров алгоритмов (в данном случае в качестве таковых выступают коэффициенты регуляризации и параметры базисных функций).

Необходимая теория

Линейная регрессия

Рассматривается задача регрессии. Имеется обучающая выборка , где

— вектор признаков для объекта

, а

— значение его регрессионной переменной. Задача заключается в предсказании значения регрессионной переменной

для объекта, представленного своим вектором признаков

.

В линейной регрессии предсказание осуществляется с помощью линейной функции:

,

где — веса линейного решающего правила, а

— фиксированные базисные функции (новые признаки). Примеры базисных функций:

- Исходные признаки:

;

- Полиномиальные базисные функции:

— степень полинома;

- Радиальные базисные функции:

, где

, а

— некоторые заранее выбранные опорные объекты, например, объекты обучающей выборки.

Веса линейного решающего правила настраиваются с помощью минимизации регуляризованного критерия наименьших квадратов:

.

Здесь — задаваемый пользователем параметр регуляризации. Данный функционал может быть минимизирован аналитически:

.

Логистическая регрессия

Рассматривается задача классификации на два класса. Имеется обучающая выборка , где

— вектор признаков для объекта

, а

— его метка класса. Задача заключается в предсказании метки класса

для объекта, представленного своим вектором признаков

.

В логистической регрессии предсказание метки класса осуществляется по знаку линейной функции:

Здесь веса и базисные функции

вводятся аналогично случаю линейной регрессии. Веса

решающего правила настраиваются с помощью минимизации следующего регуляризованного критерия:

.

Здесь — задаваемый пользователем параметр регуляризации. Функционал

является выпуклой функцией относительно своих параметров

и поэтому может быть эффективно минимизирован с помощью любого итерационного метода безусловной оптимизации, учитывающего значения градиента и гессиана функции

, например, метода Ньютона.

Скользящий контроль

В алгоритмах линейной/логистической регрессии параметр регуляризации , а также параметры базисных функций (например, степень полинома или параметр

в радиальных базисных функциях) являются структурными параметрами, которые

не могут быть настроены путем минимизации критерия

на обучающей выборке. Для их настройки используются критерии выбора модели, например, скользящий контроль.

Обозначим обучающую выборку через , а через

результат прогноза (значение регрессионной переменной или метки класса) для объекта

, полученный с помощью алгоритма

, обученного по выборке

.

При

-кратном скользящем контроле обучающая выборка

разбивается на

равных частей

. Общая величина ошибки на

-кратном скользящем контроле вычисляется как

.

Здесь через обозначена обучающая выборка без части

, а через

— величина ошибки между предсказанием

и истинным значением

. Эта ошибка вычисляется как

— для задачи регрессии и

— для задачи классификации.

Наиболее популярная версия скользящего контроля — усреднение по пяти независимым запускам 2-кратного скользящего контроля. При таком подходе необходимо обучать алгоритм только по половине обучающей выборки (что происходит быстрее, чем обучение, например, по 9/10 от объема обучающей выборки). Во-вторых, здесь требуется всего 10 различных обучений (что гораздо меньше, чем, например, объем обучающей выборки

при разбиении выборки на

частей).

Настройка параметра регуляризации с помощью скользящего контроля производится следующим образом. Выбирается набор возможных значений

, например,

. Для каждого из этих значений вычисляется величина ошибки скользящего контроля (например, с помощью усреднения по пяти запускам 2-кратного скользящего контроля). В результате выбирается такое значение

, для которого величина ошибки является наименьшей. В том случае, если требуется настроить два параметра, например

и

в радиальных базисных функциях, то выбирается двухмерная сетка значений параметров и находится та пара, для которой ошибка на скользящем контроле является наименьшей.

Схема решения задач классификации/регрессии

В простейшем случае для решения задачи классификации/регрессии имеющаяся в распоряжении выборка разбивается на три подвыборки: обучающую, валидационную и тестовую. Сначала выбирается некоторая модель алгоритмов, например, линейная регрессия с полиномиальными базисными функциями. По обучающей выборке в скользящем контроле настраиваются все структурные параметры выбранной модели (для линейной регрессии с полиномиальными базисными функциями в качестве таковых выступают коэффициент регуляризации и степень полинома). Затем с выбранными значениями структурных параметров производится обучение модели алгоритмов по обучающей выборке. Полученный алгоритм тестируется на обучающей и валидационной выборке. В том случае, если значения обеих ошибок значимо отличаются друг от друга (следовательно, есть переобучение) или их значения близки между собой и достаточно большие (значит, есть недообучение), то выбранная модель алгоритмов признается неудачной и выбирается другая модель алгоритмов (более простая, если ранее было обнаружено переобучение, или более сложная, если ранее было обнаружено недообучение). После того, как удается найти хорошую модель алгоритмов (у которой нет переобучения и недообучения), обучающая и валидационная выборка объединяются между собой и используются в качестве обучающей для настройки структурных параметров по скользящему контролю и последующего обучения в найденной хорошей модели алгоритмов. Затем полученный алгоритм тестируется на объединенной обучающей и тестовой выборке. Если обе ошибки близки между собой и достаточно маленькие по значению, то такой алгоритм признается оптимальным для решения задачи классификации/регрессии.

Зачастую имеющаяся в распоряжении выборка прецедентов является небольшой по объему и поэтому не может быть разбита на три достаточно репрезентативные подвыборки. В этом случае выборка разбивается только на обучающую и валидационную, и найденная по описанной выше схеме наилучшая модель алгоритмов не тестируется на отдельной тестовой выборке. Такой подход является менее корректным по сравнению с предыдущим, т.к. мерой качества алгоритма здесь выступает величина, которая подвергалась оптимизации на имеющихся данных. Поэтому здесь возможен эффект переобучения на уровне моделей алгоритмов. Тем не менее, во многих практических ситуациях данная схема дает вполне приемлемый результат.

Формулировка задания

Для выполнения задания необходимо выполнить следующие пункты:

| 1. Реализовать процедуру обучения/тестирования/подбора структурных параметров линейной регрессии по описанному ниже прототипу; |

| 2. Продемонстрировать на модельных данных для линейной регрессии эффект переобучения (маленькая ошибка на обучении, большая ошибка на тесте), эффект недообучения (ошибки на обучении и тесте близки между собой и большие по величине) и ситуацию нормальной работы (ошибки на обучении и тесте близки между собой и маленькие по величине); |

| 3. Решить с помощью линейной регрессии практическую задачу прогноза предела прочности бетона (описание задачи см. ниже); |

| 4. Вывести и вставить в отчет формулы для градиента и гессиана функционала |

| 5. Реализовать процедуру обучения/тестирования/подбора структурных параметров логистической регрессии по описанному ниже прототипу; |

| 6. Продемонстрировать на модельных данных для логистической регрессии эффект переобучения (маленькая ошибка на обучении, большая ошибка на тесте), эффект недообучения (ошибки на обучении и тесте близки между собой и большие по величине) и ситуацию нормальной работы (ошибки на обучении и тесте близки между собой и маленькие по величине); |

| 7. Решить с помощью логистической регрессии практическую задачу определения района происхождения вина по данным его химического анализа (описание задачи см. ниже); |

| 8. Составить отчет в формате PDF обо всех проведенных исследованиях; данный отчет должен содержать необходимые графики и описание экспериментов, выводы необходимых формул, описание полученных результатов решения практических задач, общие выводы по исследованию. |

Для выполнения задания на оценку «удовлетворительно» достаточно реализовать только пункты 4–8 без семейства полиномиальных базисных функций. Для выполнения задания на оценку «хорошо» и «отлично» необходимо выполнить все пункты задания.

Спецификация реализуемых функций

Рекомендуемая среда для выполнения задания — MATLAB. При выполнении задания в среде MATLAB необходимые алгоритмы должны быть реализованы по прототипам, указанным ниже. В случае использования других сред для выполнения задания, реализуемые функции должны соответствовать прототипам, описанным ниже. Например, при программировании на языке C набор параметров для обучения должен задаваться в текстовом файле, при этом список параметров и их возможные значения следует брать из прототипов ниже.

| Обучение линейной регрессии | |||||||||

|---|---|---|---|---|---|---|---|---|---|

| a = linreg_train(X, t, options) | |||||||||

| ВХОД | |||||||||

| |||||||||

| ВЫХОД | |||||||||

|

Обратите внимание: параметры N и M определяются неявно по размеру соответствующих элементов.

| Тестирование линейной регрессии | |||

|---|---|---|---|

| [Outputs, ErrorRate] = linreg_test(a, X, t) | |||

| ВХОД | |||

| |||

| ВЫХОД | |||

|

Прототип функции обучения логистической регрессии logreg_train целиком повторяет прототип linreg_train. При этом вектор меток класса должен содержать значения только 1 и 2.

| Тестирование логистической регрессии | |||

|---|---|---|---|

| [Outputs, Answers, ErrorRate] = logreg_test(a, X, t) | |||

| ВХОД | |||

| |||

| ВЫХОД | |||

|

Рекомендации по выполнению задания

1. Эффективное программирование под MATLAB предполагает активнейшее использование векторных и матричных операций. В частности, по возможности следует избегать любых циклов. Например, для вычисления матрицы попарных расстояний между набором объектов, задаваемых матрицами и

, можно воспользоваться свойством

, что в MATLAB может быть реализовано как

normX = sum(X.^2,2);

normY = sum(Y.^2,2);

diffXY = bsxfun(@plus, bsxfun(@plus, -2*X*Y', normX), normY');

2. При работе с выборками для устойчивости всех производимых вычислений рекомендуется осуществлять нормировку выборки независимо для каждого признака таким образом, чтобы среднее значение по выборке равнялось нулю, а выборочная дисперсия — единице. При этом следует иметь в виду, что для тестовых выборок нужно использовать нормировочные коэффициенты, полученные для обучающих выборок.

3. Проверять корректность реализации обучения и тестирования линейной/логистической регрессии следует, в первую очередь, на модельных данных. Например, для проверки линейной регрессии можно сгенерировать данные с одним признаком, в которых регрессионная переменная вычисляется как значение полинома некоторой степени от значения признака со сгенерированными коэффициентами плюс небольшой нормальный шум. Тогда при обучении линейной регрессии с полиномиальными базисными функциями и правильной степенью полинома результат предсказания должен быть очень хорошим. Эту ситуацию можно отобразить и визуально. Например, для случая полинома первой степени картинка может выглядеть так:

Кроме того, при автоматическом определении степени полинома по скользящему контролю выбираемое значение степени должно совпадать или быть близким к истинному.

4. Эффекты переобучения/недообучения для линейной/логистической регрессии можно продемонстрировать следующим образом. Для линейной регрессии достаточно сгенерировать одномерные данные с полиномом 3-ей степени. Тогда обучение линейной регрессии с полиномиальными базисными функциями первой степени должно приводить к недообучению, >6-ой степени — к переобучению, а 3-ей степени — к адекватному восстановлению зависимости. Для логистической регрессии можно сгенерировать двухмерные данные с существенно нелинейной разделяющей поверхностью. Тогда обучение логистической регрессии с радиальными базисными функциями и маленьким значением должно приводить к недообучению, с большим значением

— к переобучению, а некоторое среднее значение

будет соответствовать адекватной разделяющей поверхности.

Описание практических задач

| Определение предела прочности бетона | Классификация вин по месту происхождения | ||

|---|---|---|---|

| Задача состоит в том, чтобы спрогнозировать уровень давления, при котором конкретная бетонная смесь разрушается, в зависимости от процента содержания в ней цемента, воды, возраста смеси и др. показателей. Исходные данные и подробное описание задачи можно скачать здесь. | Имеется набор вин, произведенных в одном регионе Италии, но в трех разных винодельнях. Задача состоит в том, чтобы определить конкретную винодельню (конкретное место происхождения вина) по данным химического анализа вина. Эти данные включают в себя такие параметры как крепость, содержание яблочной кислоты, содержание различных видов флавоноидов и др. Исходные данные и подробное описание задачи можно скачать здесь. | ||

Процедура сдачи задания

Оформление задания

Необходимо в срок до 1 сентября 2011 прислать выполненный вариант задания письмом по адресу bayesml@gmail.com с темой «Задание СФ, ФИО, номер группы». Убедительная просьба присылать выполненное задание только один раз с окончательным вариантом. Новые версии будут рассматриваться только в самом крайнем случае. Также убедительная просьба строго придерживаться заданной выше спецификации реализуемых функций. Очень трудно проверять большое количество заданий, если у каждого будет свой формат реализации.

Письмо должно содержать:

- PDF-файл с описанием проведенных исследований (отчет должен включать в себя описание выполнения каждого пункта задания с приведением соответствующих графиков, изображений, чисел)

- Файлы linreg_train.m, linreg_test.m, logreg_train.m, logreg_test.m или аналогичные им исполняемые файлы

- Набор вспомогательных файлов при необходимости

Защита задания

После сдачи выполненного задания и его проверки необходимо будет защитить свое задание. В том случае, если в какой-то части выполненного задания будет обнаружен плагиат с заданием другого студента, то задание не будет засчитано для обоих студентов! Защита задания будет осуществляться с помощью видео-чата для студентов СФ и во время осенних пересдач для московских студентов. Студенту будет предложен ряд вопросов по присланному коду и проведенным исследованиям. Кроме того, возможны задания по небольшой модификации кода в режиме онлайн.