Машина опорных векторов

Материал из MachineLearning.

(→Линейно разделимая выборка) |

(→Линейно разделимая выборка) |

||

| Строка 36: | Строка 36: | ||

<tex>y_i (({\bf{w}},{\bf{x}}_i ) + b) \ge 1,\quad i = 1,...,N</tex>, (2) | <tex>y_i (({\bf{w}},{\bf{x}}_i ) + b) \ge 1,\quad i = 1,...,N</tex>, (2) | ||

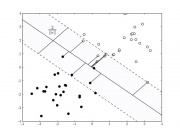

| - | где <tex>{\bf{w}}</tex> вектор весовых коэффициентов, <tex>b</tex> некоторое число. Тогда разделяющей два класса гиперплоскостью будет <tex>({\bf{w}},{\bf{x}}) + b = 0</tex>. Нетрудно видеть, что и все гиперплоскости вида <tex>({\bf{w}},{\bf{x}}) + b' = 0</tex>, где <tex>b' \in (b - 1,b + 1)</tex> также будут разделяющими (рис.1). Расстояние между граничными гиперплоскостями <tex>({\bf{w}},{\bf{x}}) + b - 1 = 0</tex> и <tex>({\bf{w}},{\bf{x}}) + b + 1 = 0</tex> равно <tex>{{\frac {{2}}{{\left\| {\bf{w}} \right\|}} </tex>. Действительно, <tex>\left( {\frac{{\bf{w}}}{{\left\| {\bf{w}} \right\|}},{\bf{x}}} \right) + \frac{{b - 1}}{{\left\| {\bf{w}} \right\|}} = 0</tex> и <tex>\left( {\frac{{\bf{w}}}{{\left\| {\bf{w}} \right\|}},{\bf{x}}} \right) + \frac{{b + 1}}{{\left\| {\bf{w}} \right\|}} = 0</tex> нормальные уравнения этих гиперплоскостей. Тогда <tex>p_1 = \frac{{b - 1}}{{\left\| {\bf{w}} \right\|}}</tex> и <tex>p_2 = \frac{{b + 1}}{{\left\| {\bf{w}} \right\|}}</tex> расстояния от этих гиперплоскостей до начала координат и <tex>{{\frac {{2}}{{\left\| {\bf{w}} \right\|}} </tex> расстояние между гиперплоскостями. На самих граничных плоскостях может находиться некоторое число (не меньше двух) обучающих векторов. Эти векторы называются ''опорными''.[[Изображение: | + | где <tex>{\bf{w}}</tex> вектор весовых коэффициентов, <tex>b</tex> некоторое число. Тогда разделяющей два класса гиперплоскостью будет <tex>({\bf{w}},{\bf{x}}) + b = 0</tex>. Нетрудно видеть, что и все гиперплоскости вида <tex>({\bf{w}},{\bf{x}}) + b' = 0</tex>, где <tex>b' \in (b - 1,b + 1)</tex> также будут разделяющими (рис.1). Расстояние между граничными гиперплоскостями <tex>({\bf{w}},{\bf{x}}) + b - 1 = 0</tex> и <tex>({\bf{w}},{\bf{x}}) + b + 1 = 0</tex> равно <tex>{{\frac {{2}}{{\left\| {\bf{w}} \right\|}} </tex>. Действительно, <tex>\left( {\frac{{\bf{w}}}{{\left\| {\bf{w}} \right\|}},{\bf{x}}} \right) + \frac{{b - 1}}{{\left\| {\bf{w}} \right\|}} = 0</tex> и <tex>\left( {\frac{{\bf{w}}}{{\left\| {\bf{w}} \right\|}},{\bf{x}}} \right) + \frac{{b + 1}}{{\left\| {\bf{w}} \right\|}} = 0</tex> нормальные уравнения этих гиперплоскостей. Тогда <tex>p_1 = \frac{{b - 1}}{{\left\| {\bf{w}} \right\|}}</tex> и <tex>p_2 = \frac{{b + 1}}{{\left\| {\bf{w}} \right\|}}</tex> расстояния от этих гиперплоскостей до начала координат и <tex>{{\frac {{2}}{{\left\| {\bf{w}} \right\|}} </tex> расстояние между гиперплоскостями. На самих граничных плоскостях может находиться некоторое число (не меньше двух) обучающих векторов. Эти векторы называются ''опорными''.[[Изображение:pic_l_1.jpg|thumb]] |

Для надежного разделения классов необходимо чтобы расстояние между разделяющими гиперплоскостями было как можно большим, т.е. <tex>\left\| {\bf{w}} \right\|</tex> была как можно меньше. Таким образом, ставится задача нахождения минимума квадратичного функционала <tex>0.5({\bf{w}},{\bf{w}})</tex> (коэффициент 0.5 вводится для удобства дифференцирования) в выпуклом многограннике, задаваемым системой неравенств (2). В выпуклом множестве квадратичный функционал всегда имеет единственный минимум (если это множество не пусто). Из теоремы Куна-Таккера следует, что решение этой оптимизационной задачи равносильно поиску седловой точки лагранжиана | Для надежного разделения классов необходимо чтобы расстояние между разделяющими гиперплоскостями было как можно большим, т.е. <tex>\left\| {\bf{w}} \right\|</tex> была как можно меньше. Таким образом, ставится задача нахождения минимума квадратичного функционала <tex>0.5({\bf{w}},{\bf{w}})</tex> (коэффициент 0.5 вводится для удобства дифференцирования) в выпуклом многограннике, задаваемым системой неравенств (2). В выпуклом множестве квадратичный функционал всегда имеет единственный минимум (если это множество не пусто). Из теоремы Куна-Таккера следует, что решение этой оптимизационной задачи равносильно поиску седловой точки лагранжиана | ||

Версия 07:20, 23 июля 2008

Машина опорных векторов — является одной из наиболее популярных методологий обучения по прецедентам, предложенной В. Н. Вапником и известной в англоязычной литературе под названием SVM (Support Vector Machine).

Оптимальная разделяющая гиперплоскость. Понятие зазора между классами (margin). Случай линейной разделимости. Задача квадратичного программирования. Опорные векторы. Случай отсутствия линейной разделимости. Функции ядра (kernel functions), спрямляющее пространство, теорема Мерсера. Способы построения ядер. Примеры ядер. Сопоставление SVM и нейронной RBF-сети. Обучение SVM методом активных ограничений. SVM-регрессия.

Содержание |

Машина опорных векторов в задачах классификации

Понятие оптимальной разделяющей гиперплоскости

Линейно разделимая выборка

Рассмотрим задачу нахождения наилучшего в некотором смысле разделения множества векторов на два класса с помощью линейной решающей функции. Пусть имеется множество прецедентов , где

- обучающая выборка, а

- множество меток двух классов

и

. Требуется по обучающей выборке построить линейную решающую функции, т.е. такую линейную функцию

, которая удовлетворяла бы условию

для всех

,

для всех

.

Без ограничения общности можно считать, что метки классов равны

Тогда поставленную выше задачу можно переформулировать следующим образом. Требуется найти линейную решающую функцию , которая бы удовлетворяла условию

для всех

(1)

Умножая, если нужно функцию на некоторое положительное число нетрудно видеть, что система неравенств (1) равносильна системе

для всех

.

Кроме того, так как линейная функция, то последняя система неравенств примет вид

где, (2)

Для надежного разделения классов необходимо чтобы расстояние между разделяющими гиперплоскостями было как можно большим, т.е. была как можно меньше. Таким образом, ставится задача нахождения минимума квадратичного функционала

(коэффициент 0.5 вводится для удобства дифференцирования) в выпуклом многограннике, задаваемым системой неравенств (2). В выпуклом множестве квадратичный функционал всегда имеет единственный минимум (если это множество не пусто). Из теоремы Куна-Таккера следует, что решение этой оптимизационной задачи равносильно поиску седловой точки лагранжиана

в ортанте по множителям Лагранжа , при условии, что

.

Последнее условие равносильно тому, что

или

(3)

Из необходимых условий существования седловой точки (полагая ) имеем

Откуда следует, что вектор следует искать в виде

, (4)

причем

. (5)

В силу (3) в сумму (4) с ненулевыми коэффициентами входят только те векторы, для которых

. Такие векторы называют опорными, так как это именно те векторы, через которые будут проходить граничные гиперплоскости, разделяющие классы. Для найденного весового вектора

смещение

можно вычислить как

для любого опорного вектора

.

Найдем значения множителей Лагранжа, как критических точек лагранжиана. Для этого подставим (4) и (5) в лагранжиан, получим

.

Таким образом, задача сводится к нахождению критических точек функции

. (6)

Так как эта функция представляет собой разность линейной и квадратичной функций, причем квадратичная функция отрицательно определена, то требуется найти наибольшее значение функции при условии

в области

. Существует много алгоритмов (в теории оптимизации) решения этой задачи (например, градиентные методы, метод покоординатного спуска и т.д.).

Замечания. 1) Суммирования в (6) осуществляются не по всем векторам, а только по опорным, которых может быть гораздо меньше, чем обучающих.

2) Линейная решающая функция в результате имеет вид

,

где зависят только

и от значений скалярного произведения

, причем суммирования осуществляются только по опорным векторам.

3) После того, как решающая функция вычислена, вектор

следует относить классу

, если

и классу

, если

. Вероятность неправильной классификации можно оценить с помощью некоторой непрерывно убывающей функции

, удовлетворяющей условиям:

,

при

. Тогда вероятность

неправильной классификации вектора

будет равна

, если

(

), где

:

,

. То есть

, если

.

4) В такой постановке алгоритм линейный классификации был разработан В. Вапником в 1963 году.

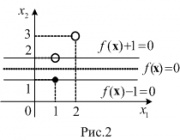

Пример. Методом опорных векторов разделите классы и

, если

,

,

.

Решение. Положим ,

,

. Тогда функция

будет иметь вид

,

причем . Тогда

. Составим и решим нормальную систему для функции

:

Следовательно, ,

,

. Так как

, то исследуем функцию

на границе области

при условии

. Если

, то

. Пусть

. Тогда

и

,

при

. Следовательно,

,

и

.

Если же , то

и

,

при

. Следовательно,

,

и

.

Таким образом, наибольшее значение функции в области

при условии

достигается в точке

. В этом случае,

Таким образом, - 2\left( \begin{matrix}1\\ 2 \\ \end{matrix} \right) = \left( \begin{matrix} 0 \\ - 2 \\ \end{matrix} \right ),\\ b = \frac {1} {{y_1 }} - ({\bf{w}},{\bf{x}}_1 ) = 1 - (0 - 2) = 3. \end{matrix}\right.)

Линейно неразделимая выборка

Ядра и спрямляющие пространства

Наиболее распространенные ядра:

- Полиномиальное:

- Полиномиальное:

- Радиальное:

, для

Алгоритмы настройки

Машина опорных векторов в задачах регрессии

Программные реализации

Литература

- Вапник В. Н. Восстановление зависимостей по эмпирическим данным. — М.: Наука, 1979. — 448 с. (подробнее)

- Hastie, T., Tibshirani, R., Friedman, J. The Elements of Statistical Learning, 2nd edition. — Springer, 2009. — 533 p. (подробнее)